文章詳情頁

python - 用scrapy-splash爬取網站 為啥iframe下的內容沒有被返回

瀏覽:142日期:2022-08-10 09:23:22

問題描述

用scrapy-splash爬取網站 為啥iframe下的內容沒有被返回?

import scrapyfrom scrapy import Selectorclass Music163Spider(scrapy.Spider): name = 'music163' allowed_domains = ['music.163.com/#/discover/toplist'] start_urls = [’http://music.163.com/#/discover/toplist/’] def parse(self, response):print('parse:',response.text) def start_requests(self):for url in self.start_urls: yield scrapy.Request(url, self.parse, meta={’splash’: { ’endpoint’: ’render.html’, ’args’: {’wait’: 0.5, }} })

問題解答

回答1:你需要在parse中獲取iframe的url再次請求內容。

相關文章:

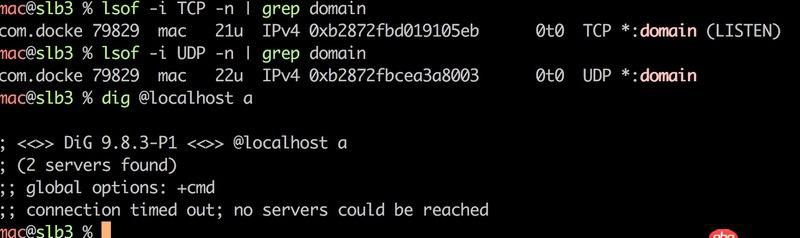

1. Docker for Mac 創建的dnsmasq容器連不上/不工作的問題2. docker安裝后出現Cannot connect to the Docker daemon.3. docker - 如何修改運行中容器的配置4. python3.x - python連oanda的模擬交易api獲取json問題第五問5. nignx - docker內nginx 80端口被占用6. css3 - 沒明白盒子的height隨width的變化這段css是怎樣實現的?7. javascript - webpack熱加載配置不生效8. javascript - QWebEngineView 如何爬 angular 的動態數據?9. java - SSH框架中寫分頁時service層中不能注入分頁類10. java - instance method中 static后的<K>是什么意思?

排行榜

網公網安備

網公網安備