文章詳情頁

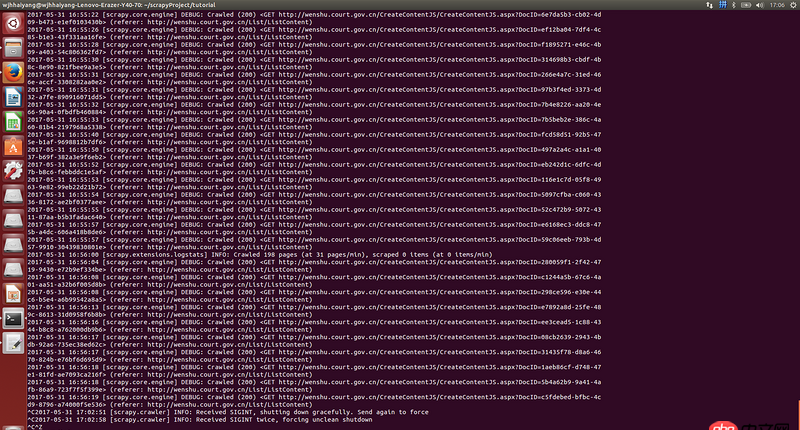

使用python scrapy框架,循環爬取URL, 每次運行一段時間后直接卡死,沒有任何報錯

瀏覽:103日期:2022-06-28 18:15:35

問題描述

每次運行半小時左右, 直接卡死, log里沒有任何報錯, 卡死的時候CPU占用率非常高

我在setting.py里設置了download timeout,不是超時的原因

ctrl-c無法正常退出, ctrl-z退出以后, 繼續執行還是同樣的問題, 半小時后再次卡死

問題解答

回答1:先TOP看看是內否過高,還是CPU過高,再找到是被哪些進程占用了如果都是你的爬蟲進程,那就得排查代碼,看看是不是哪里一直未被釋放

總之從各方面去排查吧

回答2:strace

排行榜

網公網安備

網公網安備